Chaîne de Markov sur \(E\)

Processus \((X_n)_{n\in\Bbb N}\) à valeur dans \(E\) de

Transition \(Q\) tel que \(\forall n\in{\Bbb N}\), la

Loi conditionnelle de \(X_{n+1}\) connaissant \((X_0,\dots,X_n)\) est \(Q(X_n,\cdot)\).

- intuition : la connaissance du passé ne donne pas plus d'informations que la connaissance seule du présent

- caractérisations :

- \({\Bbb P}(X_{n+1}=y|X_0=x_0,\dots,X_n=x_n)=Q(x_n,y)\)

\({\Bbb P}(X_{n+1}=y|X_0,\dots,X_n)=Q(X_n,y)\)

- conséquences :

- \(\forall\{i_1,\dots,i_k\}\in[\![0,n-1]\!]\), \({\Bbb P}(X_{n+1}=y|X_{i_1},\dots,X_{i_k},X_n)=Q(X_n,y)\)

- en particulier, \({\Bbb P}(X_{n+1}=y|X_n)=Q(X_n,y)\)

- autres caractérisations :

- \({\Bbb P}(X_0=x_0,\dots,X_n=x_n)={\Bbb P}(X_0=x_0)Q(x_0,x_1)Q(x_1,x_2)\dots Q(x_{n-1},x_n)\) la loi de \((X_0,\dots,X_n)\) est déterminée par la loi de \(X_0\) et par la matrice \(Q\)

- si \((X_n)\) est une chaîne de Markov, alors \({\Bbb E}[f(X_{n+1})|X_0,\dots,X_n]=\) \(Qf(X_n)\)

- si \((X_n)\) est une chaîne de Markov et \(Y_p:=X_{n+p}\), alors \((Y_p)_p\) est également une chaîne de Markov

- on peut toujours construire une chaîne de Markov à partir d'une Transition \(Q\) et d'un point de départ \(x\in E\)

Questions de cours

START

Ω Basique (+inversé optionnel)

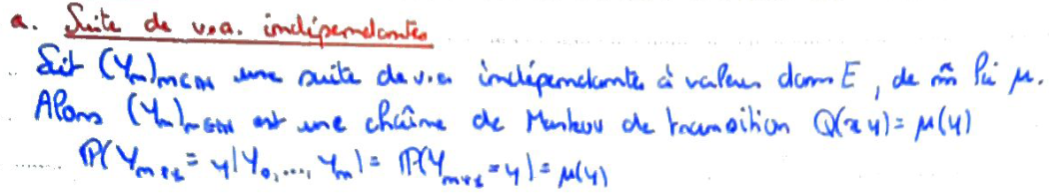

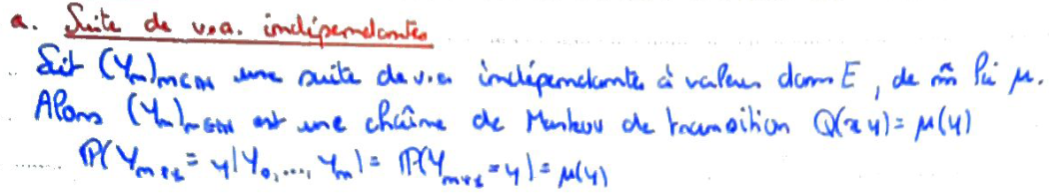

Recto: Expliquer en quoi une suite de

v.a.i.i.d constitue une chaîne de Markov.

Verso:

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

Recto: Donner un exemple de chaîne de Markov où \(E={\Bbb Z}^d\).

Verso:

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

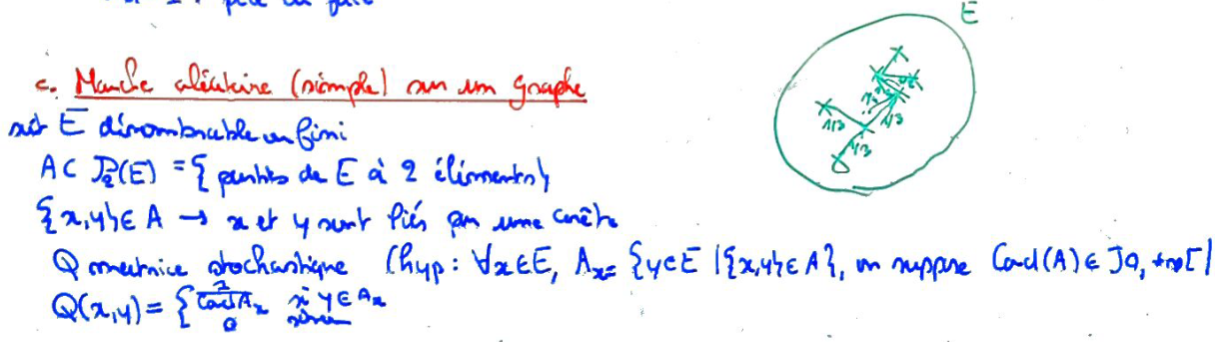

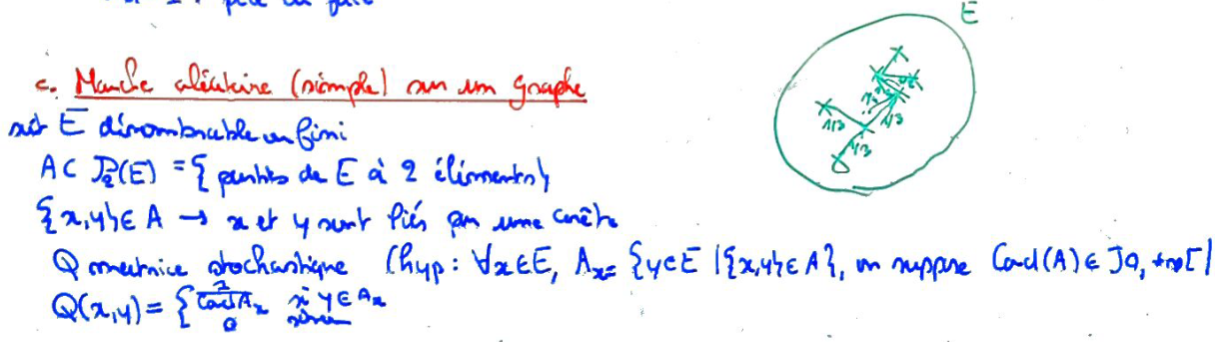

Recto: Expliquer en quoi une marche aléatoire sur un graphe peut être modélisée par une chaîne de Markov.

Verso:

Bonus:

Carte inversée ?:

END

Exercices